方案使用专题

专题一:不使用深度学习方法定位轴棒

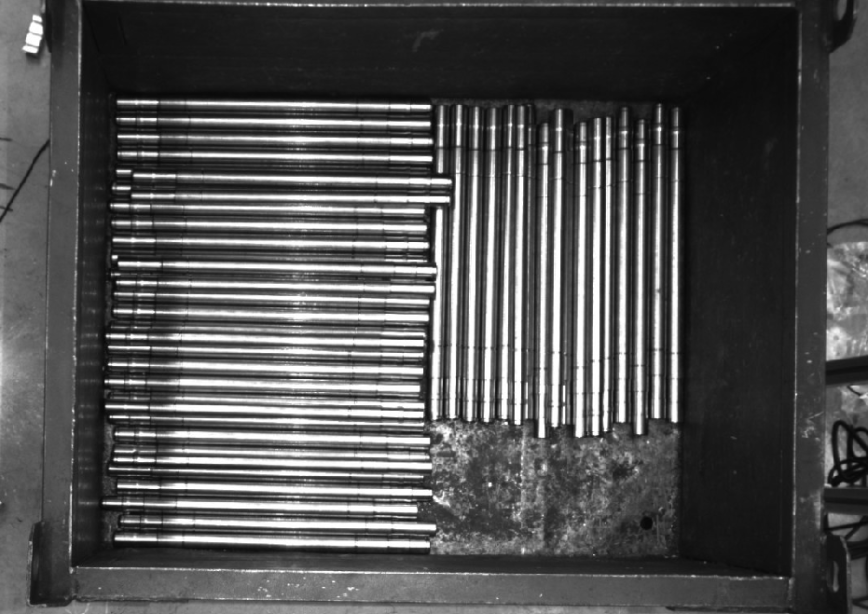

在实际项目中,若不考虑使用深度学习方法,可使用点云预处理+3D 匹配的方法来识别轴棒。

-

点云预处理:通过点云预处理分割出单个轴棒点云。

-

3D 匹配:使用“3D匹配”方法定位轴棒。

部署Mech-Vision工程

流程概览

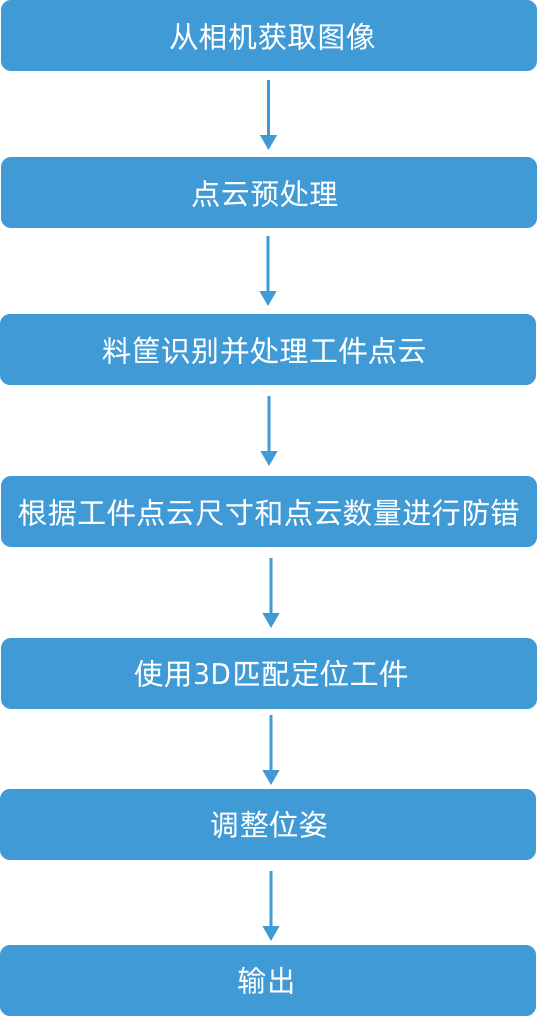

确定思路后,即可开始部署Mech-Vision工程,总体流程如下图所示。

本工程与典型工程的主要区别是:

-

本工程不使用深度学习方法识别轴棒,删除了典型工程中的通过深度学习分割出单个轴棒掩模和使用深度学习提高定位精度步骤组合。

-

本工程在典型工程的料筐识别步骤组合基础上,增加处理轴棒点云的步骤,实现了分割出单个轴棒点云的功能。

下文将对该流程中的重点步骤进行详细解释。

步骤详解

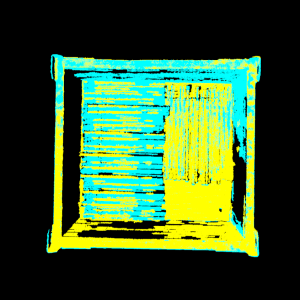

料筐识别并处理工件点云

-

功能说明:

-

识别料筐,然后输出料筐中心位姿。

-

处理并提取轴棒点云,然后使用点云聚类的方式,分割出单个轴棒点云。

-

-

内部重点步骤介绍:

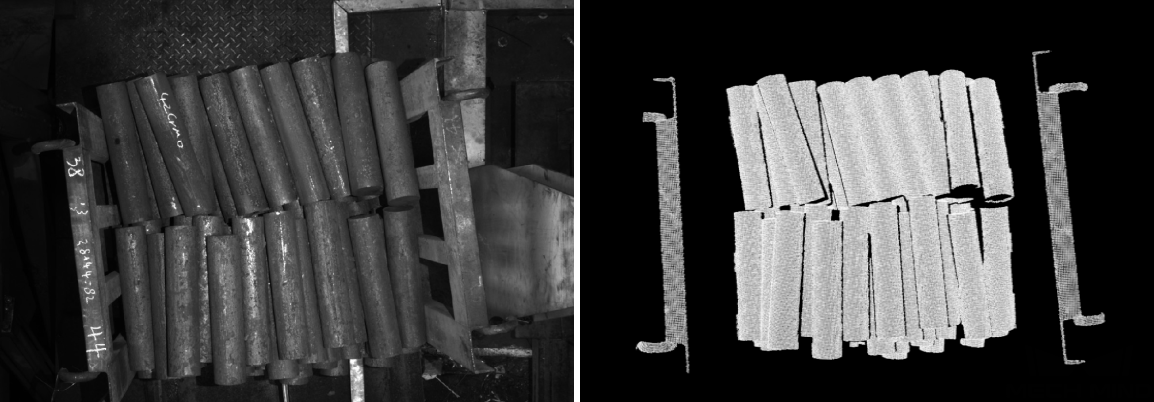

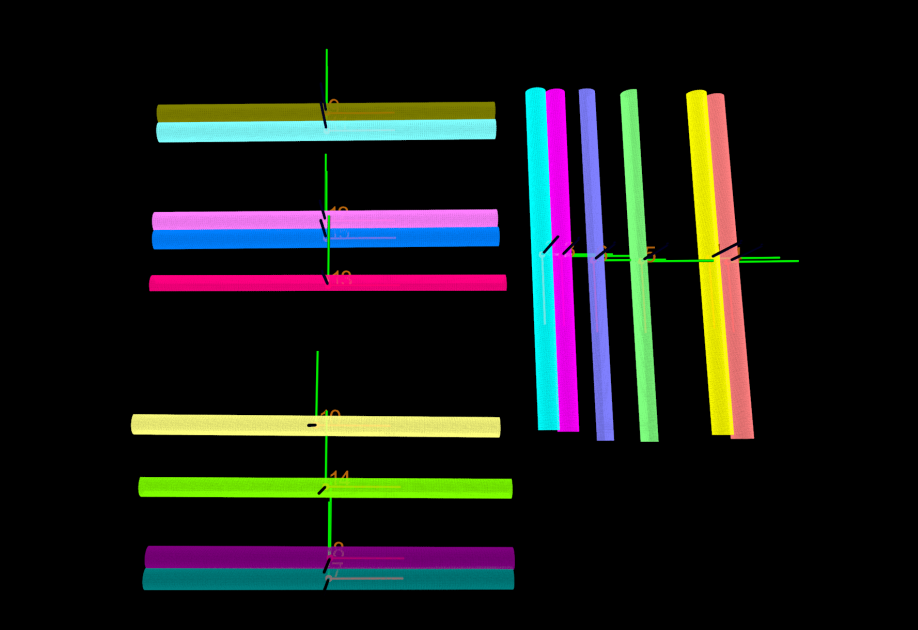

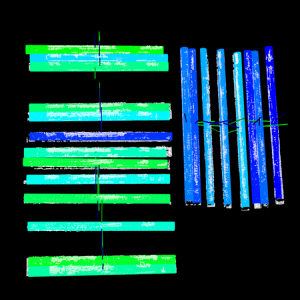

序号 参数 功能说明 效果图示 1

料筐识别

输出料筐中心位姿。

2

处理工件点云

提取轴棒点云。使用提取长方体内点云步骤,根据料筐中心位姿和料筐尺寸信息,提取轴棒点云,去除料筐点云和其他场景点云。

分割点云。使用点云聚类步骤,分割出单个轴棒点云。

专题二:使用双相机定位轴棒

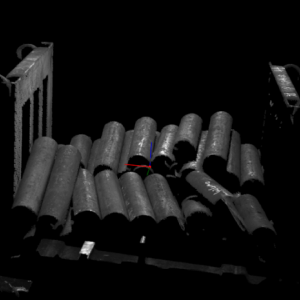

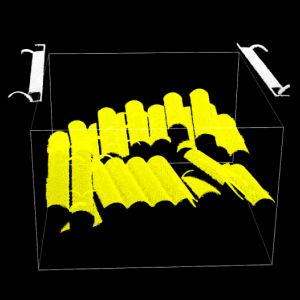

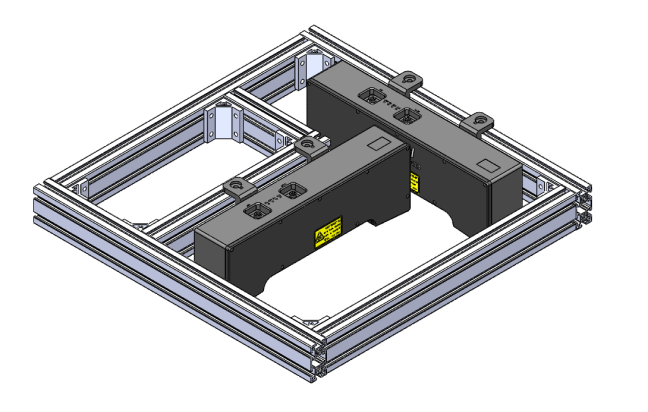

在实际项目中,还可将两个相机垂直安装(如下图所示),使两个相机的视野覆盖整个料筐,从而实现轴棒识别和定位。

部署Mech-Vision工程

流程概览

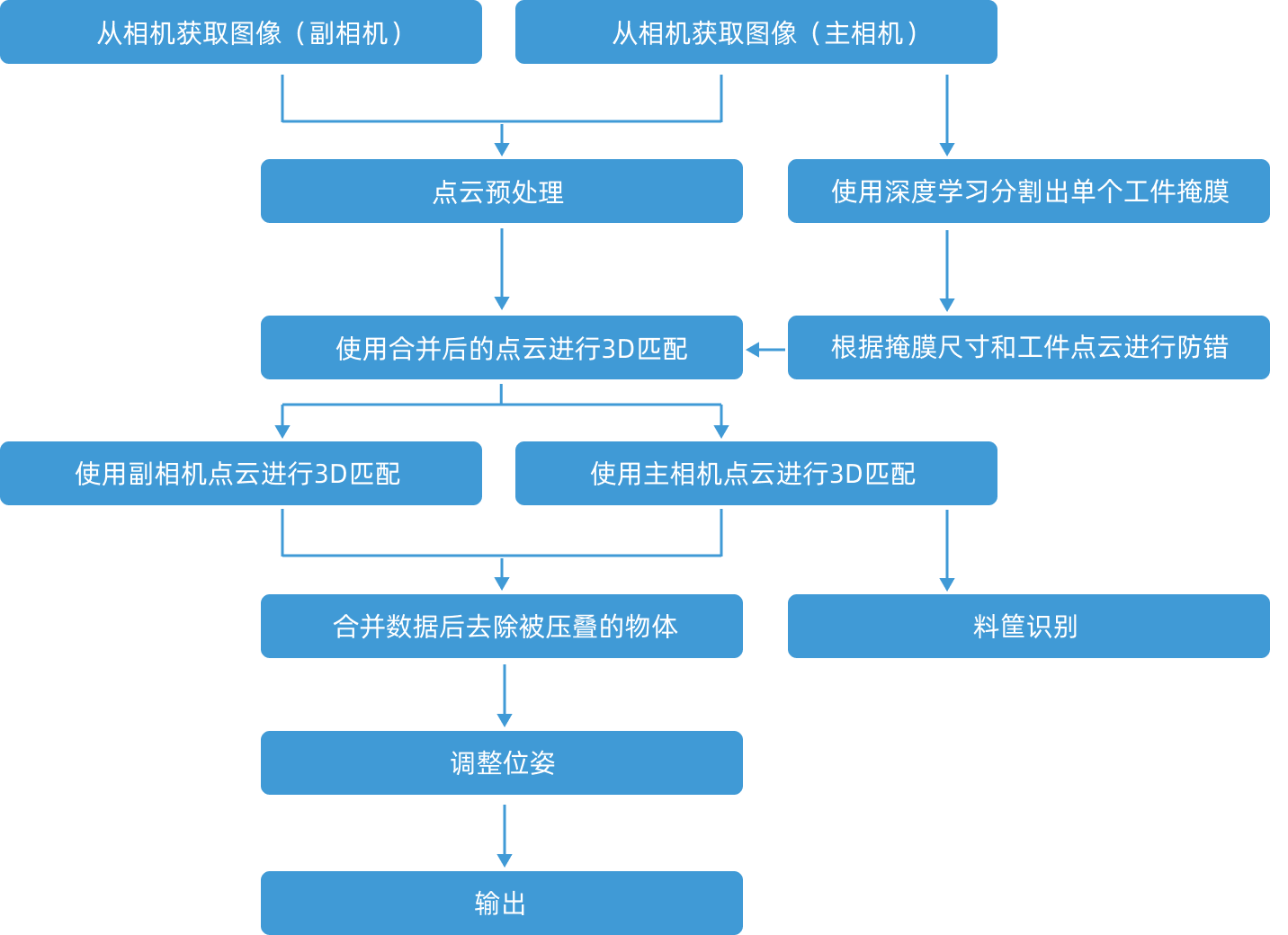

确定思路后,即可开始部署Mech-Vision工程,总体流程如下图所示。

本工程的重点思路为:

-

将双相机采集到的轴棒点云进行合并,然后进行 3D 匹配,初步确定轴棒位姿,识别轴棒朝向。

-

根据轴棒朝向的不同,分别使用主相机和副相机各自比较工件点云,然后进行 3D 匹配。

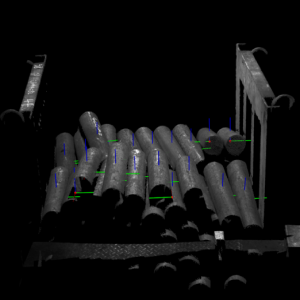

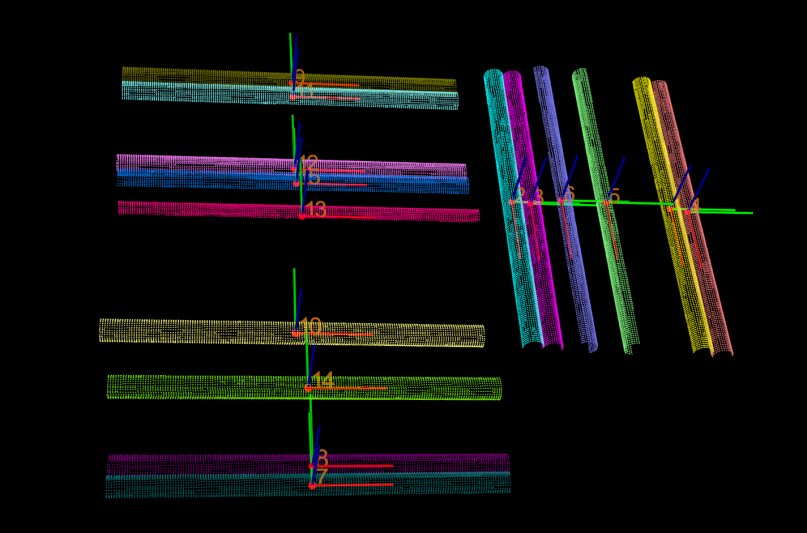

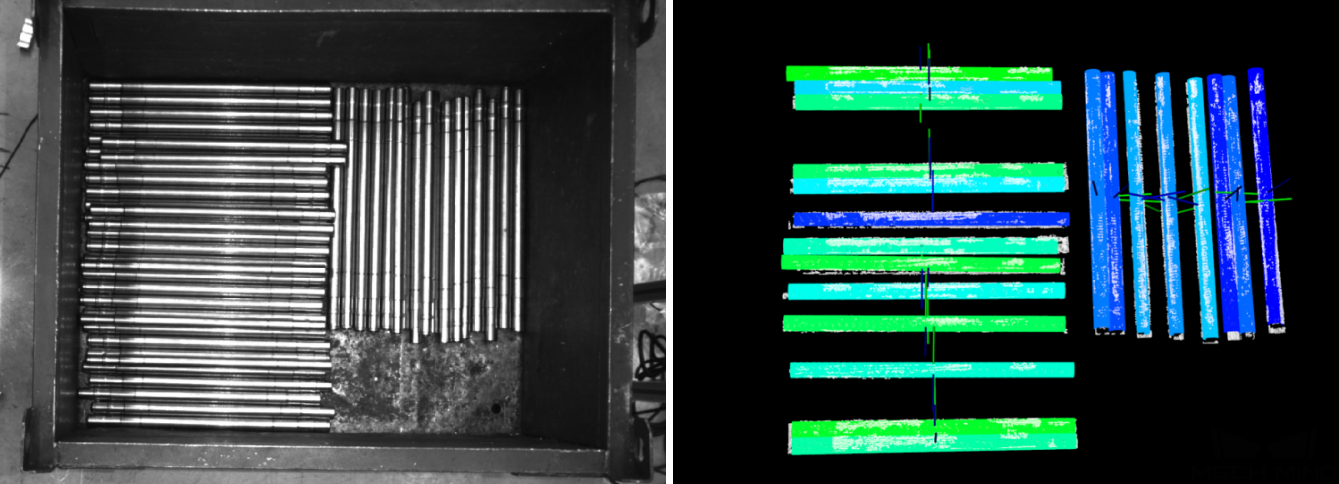

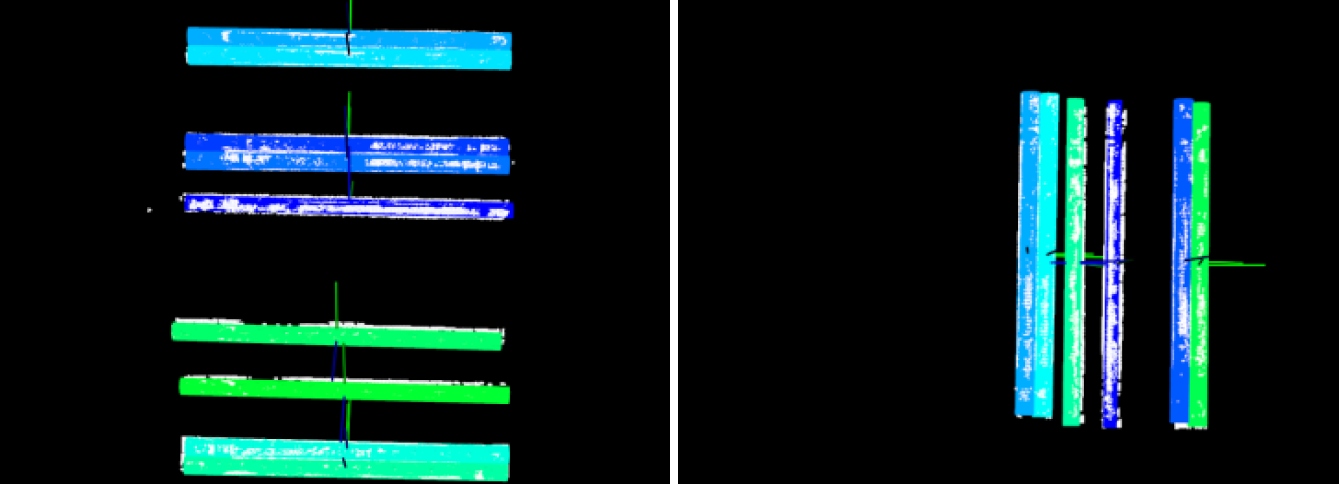

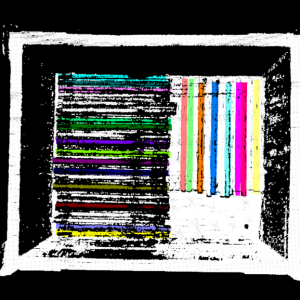

如下图所示,左图为主相机采集到的点云的 3D 匹配效果,右图为副相机采集到的点云的 3D 匹配效果。

-

将主相机和副相机识别到的轴棒位姿合并并输出。

下文将对该流程中的重点步骤进行详细解释。

步骤详解

点云预处理

-

功能说明:

合并主、副相机采集到的轴棒点云,然后对合并后的点云进行去除噪点等操作。

-

内部重点步骤介绍:

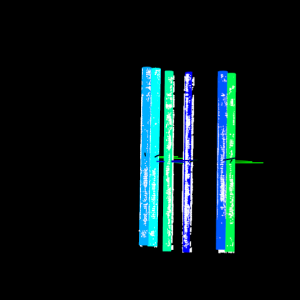

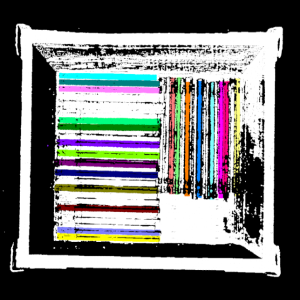

序号 参数 功能说明 效果图示 1

合并主副相机点云

将主相机、副相机采集到的轴棒点云进行合并。

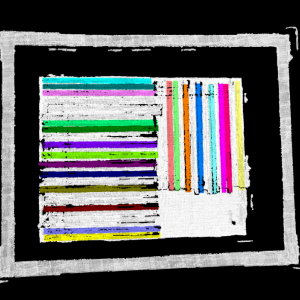

使用合并后的点云进行 3D 匹配

-

功能说明:

提取深度学习掩膜对应的轴棒点云,然后使用合并后的点云进行 3D 匹配。

-

内部重点步骤介绍:

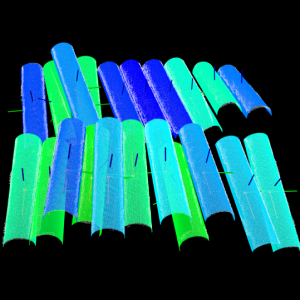

序号 参数 功能说明 效果图示 1

提取深度学习掩膜对应的工件点云

根据深度学习掩膜,将合并后的轴棒点云分割成单个的轴棒点云。

2

使用合并后的工件点云进行 3D 匹配

使用3D 匹配的方式定位轴棒,同时对两种朝向的轴棒进行点云模板匹配。

使用主/副相机点云进行 3D 匹配

-

功能说明:

-

提取深度学习掩膜对应的主相机或副相机点云。

-

使用主相机或副相机采集到的轴棒点云进行3D精匹配。

-

-

内部重点步骤介绍:

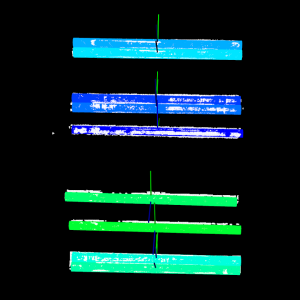

序号 参数 功能说明 效果图示 1

使用主相机点云进行3D匹配

提取深度学习掩膜对应的主相机采集到的轴棒点云。如图所示,左侧点云较完整,右侧点云有明显缺失。

使用主相机采集到的轴棒点云进行3D精匹配。因为左侧点云较好,右侧点云较差,只使用较完整的左侧工件点云进行3D匹配。

2

使用副相机点云进行3D匹配

提取深度学习掩膜对应的副相机采集到的轴棒点云。如图所示,右侧点云较完整,左侧点云有明显缺失。

使用副相机采集到的轴棒点云进行3D精匹配。因为右侧点云较好,左侧点云较差,只使用较完整的右侧工件点云进行3D匹配。