モデルを検証する

モデルをトレーニングした後、「検証」パネルに切り替えて検証を行います。検証パラメータを設定し、検証の結果を確認する方法を説明します。

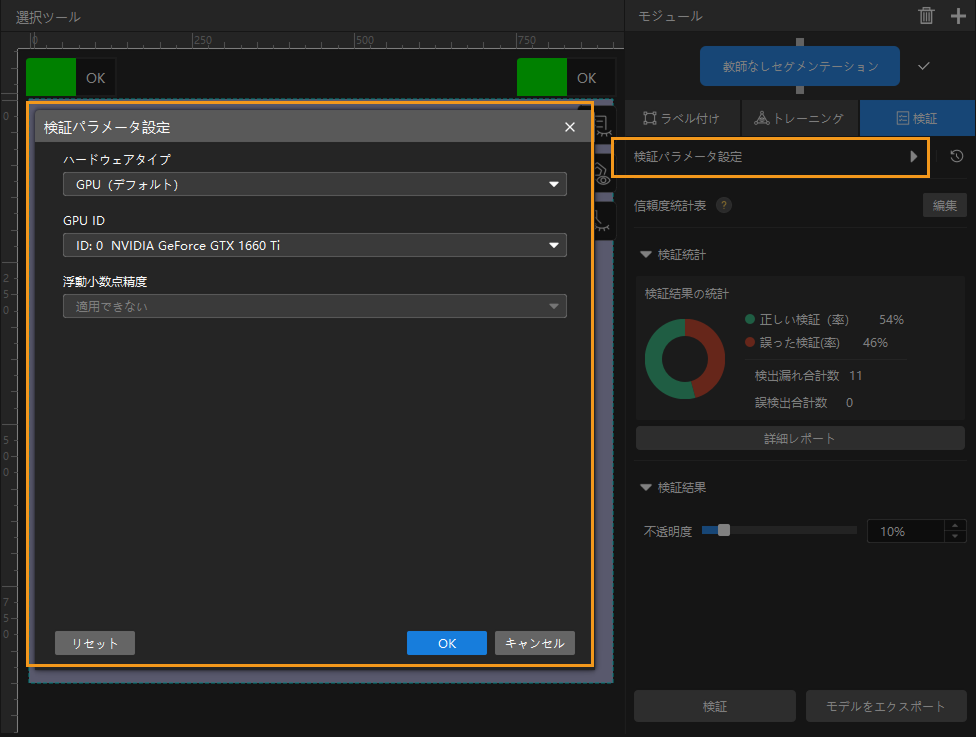

検証パラメータ設定

![]() をクリックして「検証パラメータ設定」ウィンドウを開きます。

をクリックして「検証パラメータ設定」ウィンドウを開きます。

設定可能パラメータは以下の通りです。

-

ハードウェアタイプ

-

CPU:ディープラーニングモデルの推論に CPU を使用します。これにより、GPU に比べて推論時間が長くなり、また認識精度も低下します。

-

GPU(デフォルト):ハードウェアに応じて最適化せずにモデル推論を実行します。モデル推論の速度は向上しません。

-

GPU(最適化):ハードウェアに応じて最適化してからモデル推論を実行します。最適化は 1 回だけ行い、1~20 分間かかります。推論時間を短縮可能です。

-

-

GPU ID

推論を実行するグラフィックカードの情報。複数の GPU がある場合、GPU を指定することができます。

-

浮動小数点精度

-

FP32:モデルの精度は高いですが推論の速度は遅いです。

-

FP16:モデルの精度は低いですが推論の速度は速いです。

-

-

推論目標の最大数(「インスタンスセグメンテーション」と「対象物検出」モジュールにのみ使用できる)

一回に推論を実行するインスタンスの最大数。

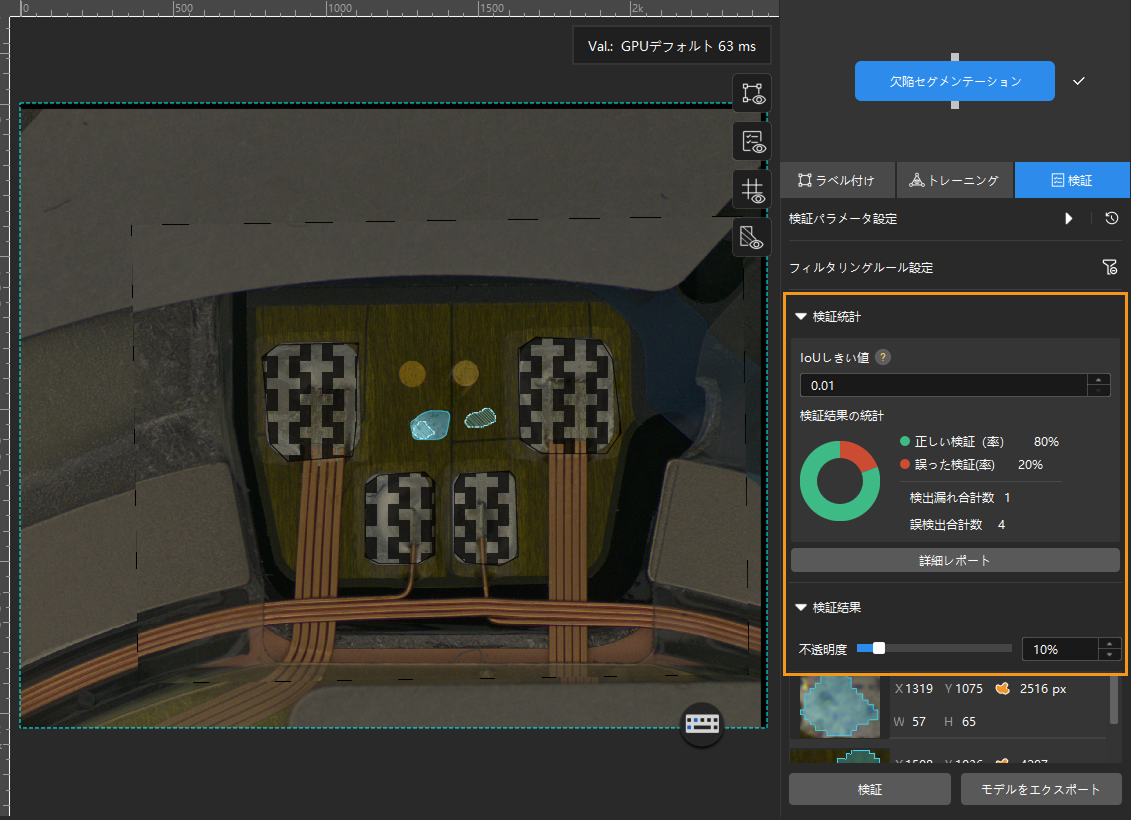

検証の結果を確認する

-

検証完了後、「検証」パラメータパネルで検証の結果を確認・フィルタリングします。

-

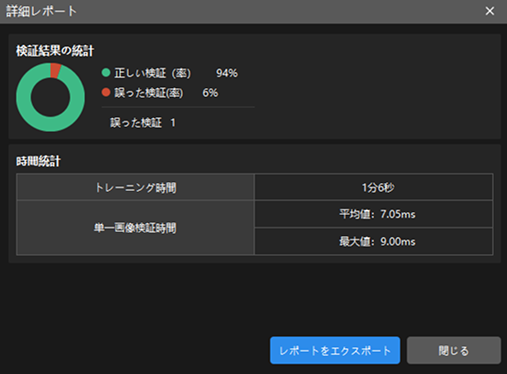

詳細レポートをクリックしてウィンドウを開き、レポートをエクスポートをクリックすればローカルに保存できます。

インスタンスセグメンテーション、欠陥セグメンテーション、画像分類、対象物検出、テキスト検出、テキスト認識、教師なしセグメンテーションモジュールは、以下にように操作します。

-

検証終了後、検証パネルの検証統計から検証の結果を確認できます。

-

詳細レポートをクリックして詳細レポートウィンドウを開いて詳細な結果データを確認します。

-

レポートのラベル付け結果マッチングには、モデル推論(検証)の結果と手動ラベルとのマッチング関係を示します。

-

表の縦は手動で付けたラベル、横は推論の結果を示します。青いセルは、両方が一致している結果で、その他は最適化が必要な結果です。

-

セルのデータをクリックすればソフトウェアのメイン画面の画像リストに対応する画像だけが表示されます。

テキスト認識モジュールは、以下のように操作します。

数の統計と検証時間の統計を確認できます。

-