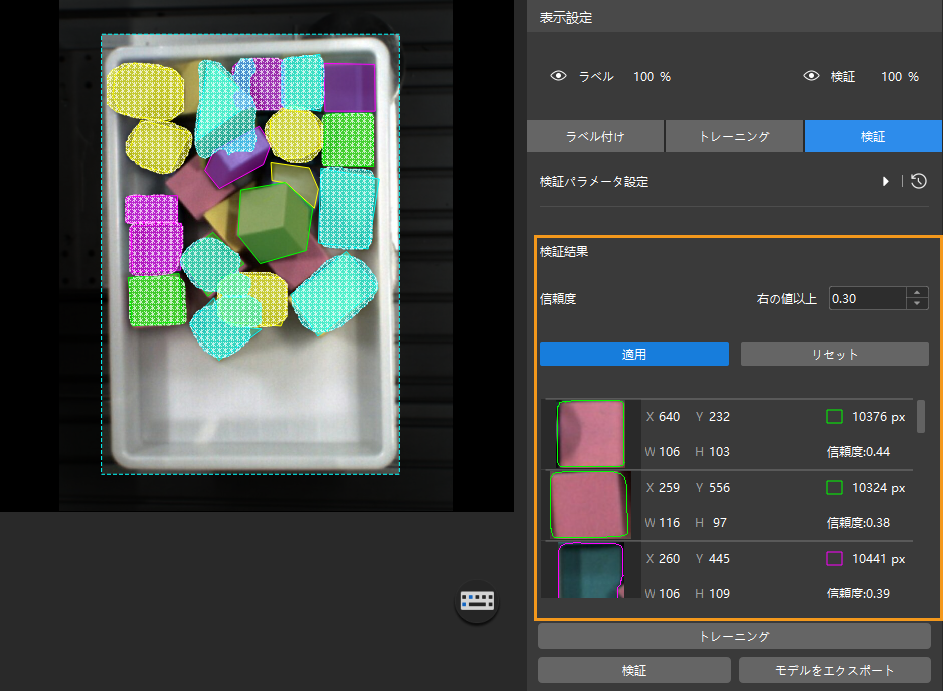

モデルを検証する

モデルをトレーニングした後、「検証」パネルに切り替えて検証を行います。検証パラメータを設定し、検証の結果を確認する方法を説明します。

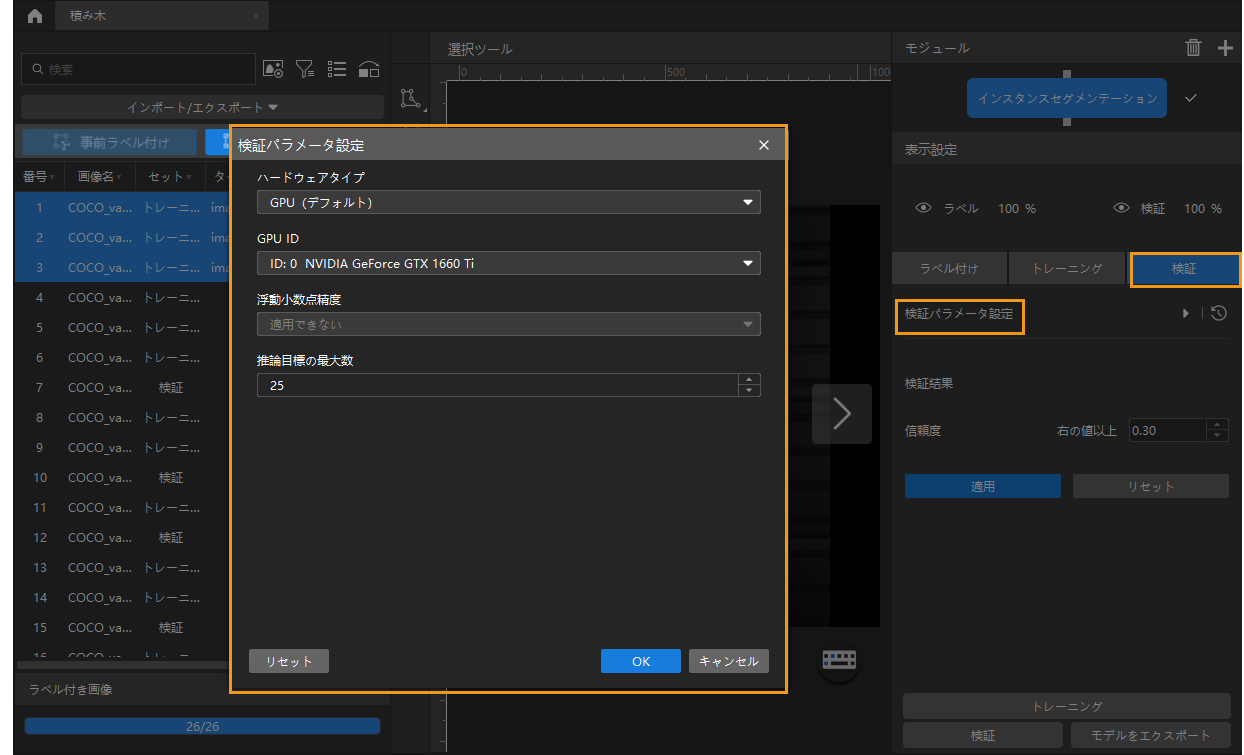

検証パラメータ設定

検証パラメータ設定をクリックして「検証パラメータ設定」ウィンドウを開きます。

設定可能パラメータは以下の通りです。

-

ハードウェアタイプ

-

CPU:ディープラーニングモデルの推論に CPU を使用します。これにより、GPU に比べて推論時間が長くなり、また認識精度も低下します。

-

GPU(デフォルト):ハードウェアに応じて最適化せずにモデル推論を実行します。モデル推論の速度は向上しません。

-

GPU(最適化):ハードウェアに応じて最適化してからモデル推論を実行します。最適化は 1 回だけ行い、5~15 分間かかります。推論時間を短縮可能です。最適化したモデルの推論時間は短縮されます。

-

-

GPU ID

推論を実行するグラフィックカードの情報。複数の GPU がある場合、GPU を指定することができます。

-

浮動小数点精度

-

FP32:モデルの精度は高いですが推論の速度は遅いです。

-

FP16:モデルの精度は低いですが推論の速度は速いです。

-

-

推論目標の最大数(「インスタンスセグメンテーション」と「対象物検出」モジュールにのみ使用できる)

一回に推論を実行するインスタンスの最大数。初期値は 100。

-

テキスト長さの上限(「テキスト認識」モジュールにのみ使用できる)

認識できるテキストの最大数。デフォルトではチェックが外れています。

-

入力画像のサイズ(「テキスト認識」モジュールにのみ使用できる)

検証時にニューラルネットワークに入力する画像の幅と高さ(単位:ピクセル)。