종이 상자 인식

이 부분을 시작하기 전에 "핸드-아이 캘리브레이션" 부분에서 "일반 공작물 인식" 샘플 프로젝트를 사용하여 Mech-Vision 솔루션을 만들어야 합니다.

이 부분에서는 먼저 프로젝트 설계를 이해한 다음 스텝 파라미터를 조정을 통해 프로젝트 배포를 완료하여 종이 상자의 포즈를 인식하고 비전 결과를 출력할 것입니다.

비디오 튜토리얼: 종이 상자 인식

|

프로젝트 설계 소개

프로젝트의 각 프로시저의 기능은 아래의 표와 같습니다.

| 번호 | 스텝/프로시저 | 예시 그림 | 기능 설명 |

|---|---|---|---|

1 |

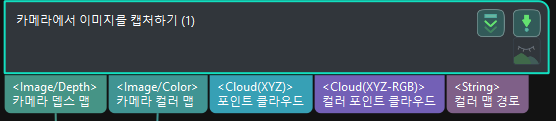

카메라에서 이미지를 캡처하기 |

|

카메라 연결 및 이미지 캡처합니다. |

2 |

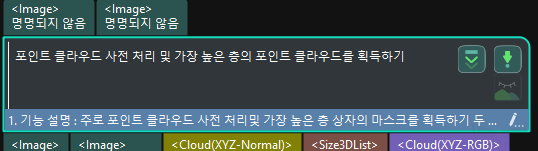

포인트 클라우드 사전 처리 및 가장 높은 층의 포인트 클라우드를 획득하기 |

|

종이 상자의 포인트 클라우드에 대해 사전 처리하고 가장 높은 층에 위치하는 상자의 마스크를 얻습니다. |

3 |

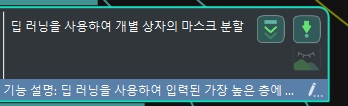

딥 러닝을 통해 단일 종이 상자의 마스크를 세그먼테이션하기 |

|

단일 종이 상자의 마스크를 이용하여 해당 포인트 클라우드를 얻을 수 있기 위해 입력한 최상층 종이 상자 마스크에 따라 딥 러닝을 사용하여 해당 영역의 단일 종이 상자 마스크를 추론합니다. |

4 |

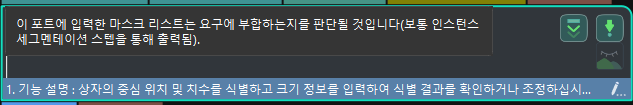

상자 포즈를 계산하기 |

|

종이 상자 포즈를 인식하고 입력한 종이 상자의 치수 정보에 의해 인식 결과를 확인하거나 조정합니다. |

5 |

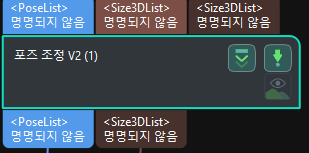

포즈 조정 V2 |

|

종이 상자 포즈의 좌표계를 변환하고 여러 상자의 포즈를 행과 열로 정렬합니다. |

6 |

출력 |

|

종이 상자의 포즈를 출력하여 로봇 피킹에 사용합니다. |

파라미터 조절에 대한 설명

이 부분에서는 각 스텝이나 프로시저의 파라미터를 조정하여 프로젝트 배포를 완료할 것입니다.

카메라에서 이미지를 캡처하기

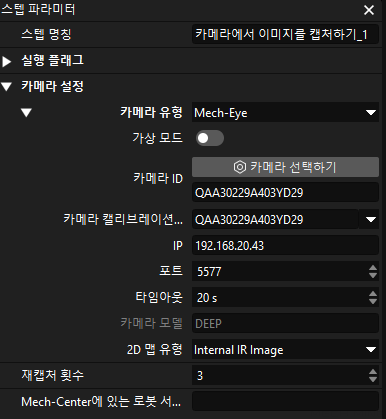

“동일한 종류의 상자” 샘플 프로젝트에 가상 데이터가 배치되어 있기 때문에 먼저 “카메라에서 이미지를 캡처하기” 스텝의 가상 모드를 닫아야 실제 카메라와 연결됩니다.

-

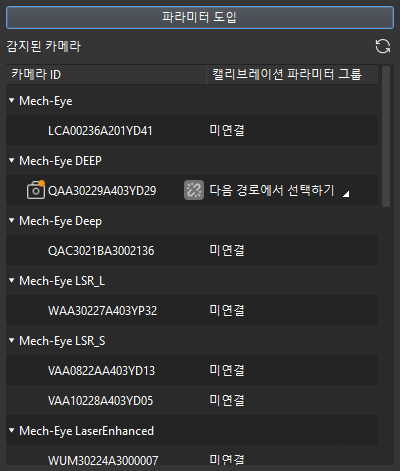

"카메라에서 이미지를 캡처하기" 스텝을 선택하고 인터페이스의 오른쪽 하단 모서리에 있는 스텝 파라미터에서 가상 모드를 닫고 카메라를 선택하기 버튼을 클릭합니다.

-

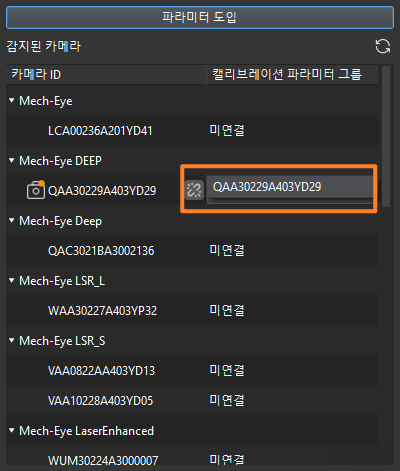

팝업창에서 연결할 카메라 번호 우측의

아이콘을 클릭하면 카메라와 연결됩니다. 카메라가 성공적으로 연결되면

아이콘을 클릭하면 카메라와 연결됩니다. 카메라가 성공적으로 연결되면  아이콘이

아이콘이  로 변경됩니다.

로 변경됩니다.

카메라 연결 후 파라미터 그룹을 선택해야 합니다. 파라미터 그룹 선택 버튼을 클릭하여 캘리브레이션된 파라미터 그룹(ETH/EIH와 날짜 정보가 표시됨)을 선택합니다.

-

카메라를 연결하고 파라미터 그룹을 설정하면 카메라 캘리브레이션 파라미터 그룹, IP 주소 및 포트와 같은 파라미터가 자동으로 획득되며 나머지 파라미터는 기본값으로 유지하면 됩니다.

이때 카메라가 성공적으로 연결됩니다.

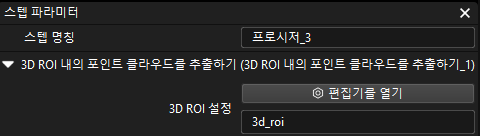

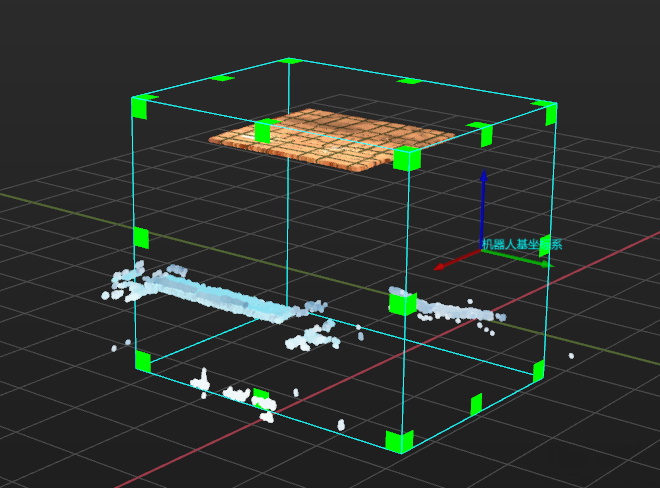

포인트 클라우드 사전 처리 및 가장 높은 층의 마스크를 획득하기

최상층이 아닌 종이 상자를 피킹해서 로봇이 다른 상자와 충돌하는 것을 피하기 위해 이 프로시저에서 최상층 종이 상자의 포인트 클라우드를 얻어 로봇이 우선적으로 최상층 상자를 피킹하는 것을 가이드해야 합니다.

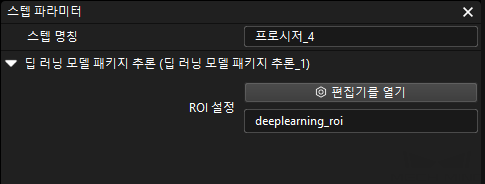

딥 러닝을 통해 단일 종이 상자의 마스크를 세그먼테이션하기

최상층 상자의 포인트 클라우드를 얻은 후에는 딥 러닝을 통해 단일 종이 상자의 마스크를 세그먼테이션합니다.

-

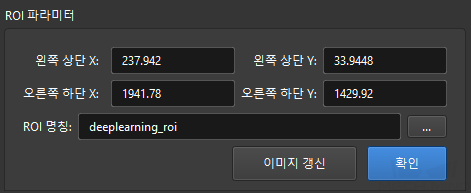

딥 러닝을 통해 단일 종이 상자의 마스크를 세그먼테이션하기 프로시저의 파라미터 패널에서 편집기를 열기 버튼을 클릭하여 ROI 설정 창을 엽니다.

-

ROI 설정 창에서 2D ROI를 설정합니다. 2D ROI는 가장 높은 층에 있는 상자를 덮어야 하며 약 1/3 여백을 남겨두는 것이 좋습니다.

-

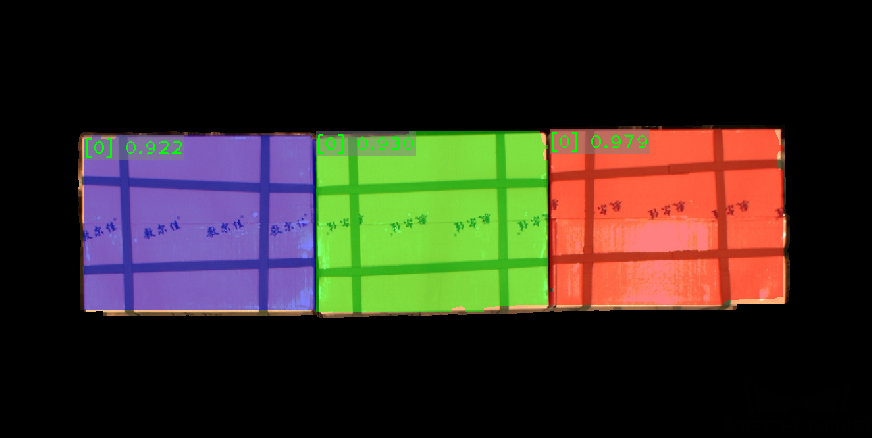

현재 샘플 프로젝트에는 종이 상자의 일반적인 인스턴스 세그먼테이션 모델 패키지가 내장되어 있습니다. 아래 그림과 같이 이 프로시저를 실행하여 단일 상자의 마스크를 얻습니다.

|

세그먼테이션 효과가 충분하지 않은 경우 2D ROI의 크기를 적절하게 조정할 수 있습니다. |

상자 포즈를 계산하기

단일 상자의 포인트 클라우드를 얻은 후 상자의 포즈를 계산할 수 있습니다. 이 밖에 입력한 상자의 치수를 통해 비전 인식 결과의 정확성를 확인할 수 있습니다.

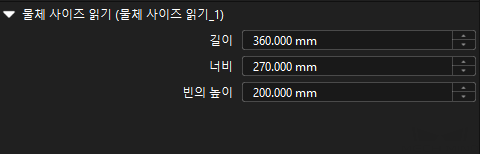

상자 포즈 계산 프로시저는 상자의 포즈와 치수를 계산하는 데 사용됩니다. 이 프로시저의 파라미터를 설정할 필요는 없습니다.